چگونه بلاگر شویم ؟ + آموزش و نکات صفر تا 100 بلاگر شدن در اینستاگرام و…🚨

می 30, 2023

یونیکس (Unix) چیست؟ + اجزای سیستم عامل + تاریخچه + مقایسه با لینوکس 🟢

ژوئن 3, 2023دیپ فیک یکی از موضوعات جدیدی است که با ورود هوش مصنوعی به دننیا معرفی شده است. دیپ فیک از تمام موضوعاتی که هوش مصنوعی به نوعی خطرناک تر است!. به این دلیل که می تواند شبیه سازی هایی را انجام دهد که افراد را تهدید، ترغیب و … کند. ممکن است شما یک سخنرانی از یک فرد معروف ببینید که سخنان خاصی را می گوید و در واقع سخنان او نیست!. بنابراین بهتر است با این بخش از هوش مصنوعی آشنا شوید. چون ممکن است به زودی کلاهبردار های به این سمت پیش می روند. با ما همراه باشید تا بتوانید از این کلاهبرداری های جلوگیری کنید.

آنچه در این مقاله خواهید خواند :

دیپ فیک AI چیست؟

هوش مصنوعی Deepfake نوعی هوش مصنوعی است که برای ایجاد تصاویر متقاعد کننده، فریب های صوتی و تصویری استفاده می شود. این اصطلاح هم فناوری و هم محتوای جعلی ناشی از آن را توصیف میکند و یک نمونه از یادگیری عمیق و جعلی است. دیپ فیک ها اغلب محتوای منبع موجود را تغییر میدهند، جایی که یک نفر با دیگری عوض میشود. آنها همچنین محتوای کاملاً اصلی را ایجاد می کنند که در آن شخصی در حال انجام یا گفتن چیزی است که انجام نداده یا نگفت.

بزرگترین خطری که دیپ فیک ایجاد می کند، توانایی آنها در انتشار اطلاعات نادرست است که به نظر می رسد از منابع قابل اعتماد آمده است. به عنوان مثال، در سال 2022 یک ویدیوی دیپ فیک از ولدیمیر زلنسکی، رئیس جمهور اوکراین منتشر شد که از سربازانش می خواهد تسلیم شوند. همچنین نگرانی هایی در مورد احتمال دخالت در انتخابات و تبلیغات انتخاباتی مطرح شده است. در حالی که دیپ فیک ها تهدیدهای جدی هستند، کاربردهای قانونی نیز دارند، مانند صدا و سرگرمی بازی های ویدیویی، و برنامه های کاربردی پشتیبانی مشتری و پاسخ به تماس گیرندگان، مانند خدمات ارسال تماس و پذیرش.

دیپ فیک چگونه کار می کند؟

Deepfakes از دو الگوریتم – یک مولد و یک تمایز – برای ایجاد و اصلاح محتوای جعلی استفاده می کند. مولد یک مجموعه داده آموزشی را بر اساس خروجی مورد نظر ایجاد می کند و محتوای دیجیتال جعلی اولیه را ایجاد می کند، در حالی که تمایزکننده تجزیه و تحلیل می کند که نسخه اولیه محتوا چقدر واقعی یا جعلی است. این فرآیند تکرار میشود و به تولیدکننده اجازه میدهد در ایجاد محتوای واقعبینانه بهبود یابد و متمایزکننده در تشخیص نقصها برای اصلاح ژنراتور ماهرتر شود.

ترکیبی از الگوریتمهای مولد و تفکیککننده، یک شبکه متخاصم مولد ایجاد میکند. یک GAN از یادگیری عمیق برای تشخیص الگوها در تصاویر واقعی استفاده می کند و سپس از آن الگوها برای ایجاد جعلی استفاده می کند. هنگام ایجاد یک عکس عمیق، یک سیستم GAN عکسهای هدف را از زوایای مختلفی مشاهده میکند تا تمام جزئیات و چشم اندازها را ثبت کند. هنگام ایجاد یک ویدیوی دیپ فیک، GAN ویدیو را از زوایای مختلف مشاهده می کند و همچنین رفتار، حرکت و الگوهای گفتار را تجزیه و تحلیل می کند. سپس این اطلاعات چندین بار از طریق تشخیص دهنده اجرا می شود تا واقع گرایی تصویر یا ویدیوی نهایی را تنظیم کند.

ویدیوهای Deepfake به یکی از دو روش ایجاد می شوند. آنها می توانند از یک منبع ویدیویی اصلی از هدف استفاده کنند، جایی که فرد مجبور می شود کارهایی را که هرگز انجام نداده است بگوید و انجام دهد. یا میتوانند چهره فرد را با ویدیوی فرد دیگری که به عنوان تعویض چهره نیز شناخته میشود، عوض کنند.

بیشتر بخوانید🚀🚀🚀🚀🚀🚀 درآمد از هوش مصنوعی

در زیر چند رویکرد خاص برای ایجاد دیپ فیک وجود دارد:

منبع دیپ فیک ویدیو

هنگام کار از یک ویدیوی منبع، یک رمزگذار خودکار عمیق مبتنی بر شبکه عصبی، محتوا را برای درک ویژگیهای مرتبط هدف، مانند حالات چهره و زبان بدن، تجزیه و تحلیل میکند. سپس این ویژگی ها را به ویدیوی اصلی تحمیل می کند. این رمزگذار خودکار شامل یک رمزگذار است که ویژگی های مربوطه را رمزگذاری می کند. و یک رمزگشا، که این ویژگی ها را به ویدیوی مورد نظر تحمیل می کند.

دیپ فیک های صوتی

برای دیپفیکهای صوتی، یک GAN صدای صدای یک فرد را شبیهسازی میکند، مدلی را بر اساس الگوهای صوتی ایجاد میکند و از آن مدل استفاده میکند تا صدا را هر چیزی که سازنده میخواهد بگوید. این تکنیک معمولا توسط توسعه دهندگان بازی های ویدیویی استفاده می شود.

همگام سازی لب

همگام سازی لب یکی دیگر از روش های رایج مورد استفاده در دیپ فیک است. در اینجا، دیپ فیک صدای ضبط شده را به ویدیو نگاشت می کند و به نظر می رسد که شخص در ویدیو در حال صحبت کردن کلمات ضبط شده است. اگر صدا به خودی خود یک دیپ فیک باشد، پس ویدیو لایه دیگری از فریب را اضافه می کند. این تکنیک توسط شبکه های عصبی مکرر پشتیبانی می شود.

دیپ فیک برای تشکیل شدن باید ابعاد صورت شما را تشخیص دهد

با توسعه و پیشرفت فناوریهای زیر، توسعه Deep fake آسانتر، دقیقتر و رایجتر میشود:

فناوری شبکه عصبی GAN در توسعه تمام محتوای دیپ فیک با استفاده از الگوریتم های مولد و تمایز استفاده می شود.

شبکه های عصبی کانولوشنال الگوها را در داده های بصری تجزیه و تحلیل می کنند. CNN ها برای تشخیص چهره و ردیابی حرکت استفاده می شوند.

رمزگذار خودکار یک فناوری شبکه عصبی است که ویژگیهای مربوط به یک هدف مانند حالات صورت و حرکات بدن را شناسایی میکند و سپس این ویژگیها را به ویدیوی منبع تحمیل میکند.

پردازش زبان طبیعی برای ایجاد صدای دیپ فیک استفاده می شود. الگوریتمهای NLP ویژگیهای گفتار هدف را تجزیه و تحلیل میکنند و سپس متن اصلی را با استفاده از آن ویژگیها تولید میکنند.

محاسبات با کارایی بالا نوعی از محاسبات است که توان محاسباتی لازم قابل توجه مورد نیاز دیپ فیک را فراهم می کند.

بر اساس گزارش وزارت امنیت داخلی ایالات متحده “تهدید فزاینده هویت های عمیق جعلی”، چندین ابزار معمولا برای تولید دیپ فیک در عرض چند ثانیه استفاده می شود. این ابزارها عبارتند از Deep Art Effects، Deepswap، Deep Video Portraits، FaceApp، FaceMagic، MyHeritage، Wav2Lip، Wombo و Zao.

نحوه مقایسه یادگیری ماشین، یادگیری عمیق و شبکه های عصبی یادگیری ماشینی، یادگیری عمیق و شبکه های عصبی برخی از فناوری های کلیدی هستند که برای توسعه دیپ فیک استفاده می شوند.

دیپ فیک معمولا چگونه استفاده می شود؟

استفاده از دیپ فیک به طور قابل توجهی متفاوت است. کاربردهای اصلی شامل موارد زیر است:

هنر دیپ فیک برای تولید موسیقی جدید با استفاده از بدنه های موجود آثار یک هنرمند استفاده می شود.

باج گیری و آسیب به شهرت. نمونه هایی از این موارد زمانی است که یک تصویر هدف در موقعیتی غیرقانونی، نامناسب یا به گونه ای دیگر مانند دروغ گفتن به عموم، درگیر شدن در اعمال جنسی آشکار یا مصرف مواد مخدر قرار می گیرد. این ویدئوها برای اخاذی از یک قربانی، خراب کردن شهرت یک فرد، انتقام گرفتن یا صرفاً زورگویی سایبری به آنها استفاده می شود. رایج ترین باج گیری یا استفاده انتقام جویانه، جرایم عمیق جعلی غیر توافقی است که به عنوان جرایم انتقامی نیز شناخته می شود.

خدمات پاسخگویی به تماس گیرندگان این سرویسها از دیپ فیک برای ارائه پاسخهای شخصی به درخواستهای تماسگیرنده استفاده میکنند که شامل ارسال تماس و سایر خدمات پذیرش میشود.

پشتیبانی تلفنی مشتری این سرویس ها از صداهای جعلی برای کارهای ساده ای مانند بررسی موجودی حساب یا ثبت شکایت استفاده می کنند.

سرگرمی. فیلمهای هالیوودی و بازیهای ویدیویی صدای بازیگران را برای صحنههای خاصی شبیهسازی و دستکاری میکنند. رسانههای سرگرمی از این ویژگی زمانی استفاده میکنند که صحنهای به سختی فیلمبرداری میشود، در پستولید زمانی که یک بازیگر دیگر برای ضبط صدای خود در صحنه نیست، یا برای صرفهجویی در وقت بازیگر و تیم سازنده. دیپ فیک همچنین برای محتوای طنز و تقلید استفاده می شود که در آن مخاطب متوجه می شود ویدیو واقعی نیست اما از موقعیت طنز آمیزی که دیپ فیک ایجاد می کند لذت می برد. به عنوان مثال می توان به دیپ فیک سال 2023 دواین «راک» جانسون در نقش دورا کاوشگر اشاره کرد.

نکته

شواهد دروغین این شامل ساختن تصاویر یا صداهای نادرست است که می تواند به عنوان مدرکی دال بر گناه یا بی گناهی در یک پرونده قانونی استفاده شود.

تقلب دیپ فیک برای جعل هویت یک فرد برای به دست آوردن اطلاعات شناسایی شخصی (PII) مانند شماره حساب بانکی و کارت اعتباری استفاده می شود. این ممکن است گاهی اوقات شامل جعل هویت مدیران شرکت ها یا سایر کارمندان با اعتبار برای دسترسی به اطلاعات حساس باشد که یک تهدید بزرگ امنیت سایبری است.

اطلاعات غلط و دستکاری سیاسی ویدئوهای دیپ فیک سیاستمداران یا منابع مورد اعتماد برای تحت تاثیر قرار دادن افکار عمومی استفاده می شود و در مورد دیپ فیک رئیس جمهور اوکراین ولودومیر زلنسکی، سردرگمی در جنگ ایجاد می کند. گاهی اوقات از آن به عنوان انتشار اخبار جعلی یاد می شود.

دستکاری سهام مواد جعلی عمیق برای تأثیرگذاری بر قیمت سهام شرکت استفاده می شود. به عنوان مثال، یک ویدیوی جعلی از یک مدیر اجرایی که اظهارات مخربی درباره شرکت خود می کند، می تواند قیمت سهام آن را کاهش دهد. یک ویدیوی جعلی درباره یک پیشرفت تکنولوژیکی یا عرضه محصول می تواند سهام یک شرکت را افزایش دهد.

ارسال پیامک در گزارش وزارت امنیت داخلی ایالات متحده با عنوان “تهدید فزاینده هویت های عمیق جعلی” از پیام های متنی به عنوان استفاده آینده از فناوری دیپ فیک یاد شده است. بر اساس این گزارش، بازیگران تهدید میتوانند از تکنیکهای دیپفیک برای تکرار سبک پیامرسانی کاربر استفاده کنند.

بیشتر بخوانید🚀🚀🚀🚀🚀🚀 کاربرد های هوش مصنوعی

آیا Deep fake قانونی است؟

دیپ فیک ها عموما قانونی هستند و علیرغم تهدیدهای جدی که ایجاد می کنند، مجریان قانون نمی توانند در مورد آنها انجام دهند. دیپ فیک تنها در صورتی غیرقانونی است که قوانین موجود مانند پورنوگرافی کودکان، افترا یا سخنان مشوق نفرت را نقض کند.

سه ایالت قوانینی در مورد دیپ فیک دارند. به گفته مجله رئیس پلیس، تگزاس دیپفیکهایی را که هدفشان تاثیرگذاری بر انتخابات است، ممنوع میکند، ویرجینیا انتشار هرزهنگاری دیپفیک را ممنوع میکند، و کالیفرنیا قوانینی علیه استفاده از دیپفیکهای سیاسی ظرف 60 روز پس از انتخابات و هرزهنگاری عمیق غیراجماعی دارد.

فقدان قوانین علیه دیپ فیک به این دلیل است که اکثر مردم از فناوری جدید، کاربردها و خطرات آن بی اطلاع هستند. به همین دلیل، قربانیان در اکثر موارد دیپ فیک تحت حمایت قانون قرار نمی گیرند.

دیپ فیک یک نقشه راهبردی برای گول زدن ما دارد!

دیپ فیک چرا خطرناک است؟

deep fake ها علیرغم قانونی بودن، خطرات قابل توجهی دارند، از جمله موارد زیر:

باج خواهی و آسیب به شهرت که اهداف را در موقعیت های قانونی به خطر انداخته است.

اطلاعات نادرست سیاسی مانند عوامل تهدید کننده دولتهای ملت که از آن برای اهداف پلید استفاده میکنند.

تداخل در انتخابات، مانند ایجاد ویدئوهای جعلی از نامزدها.

دستکاری سهام در جایی که محتوای جعلی برای تأثیرگذاری بر قیمت سهام ایجاد می شود.

کلاهبرداری که در آن فردی جعل هویت می شود تا حساب مالی و سایر PII را سرقت کند.

روش های تشخیص Deep fake

چندین روش برتر برای شناسایی حملات دیپ فیک وجود دارد. موارد زیر نشانههایی از محتوای دیپفیک احتمالی هستند:

وضعیت غیرمعمول یا نامناسب صورت.

حرکت غیر طبیعی صورت یا بدن.

رنگ آمیزی غیر طبیعی

ویدیوهایی که با بزرگنمایی یا بزرگنمایی عجیب به نظر می رسند.

صدای ناسازگار

افرادی که پلک نمی زنند

در دیپ فیک متنی، چند شاخص وجود دارد:

غلط املایی جملاتی که به طور طبیعی جریان ندارند.

آدرس ایمیل منبع مشکوک

عبارتی که با فرستنده فرضی مطابقت ندارد.

پیامهای خارج از متن که به هیچ بحث، رویداد یا موضوعی مرتبط نیستند.

با این حال، هوش مصنوعی به طور پیوسته بر برخی از این شاخص ها غلبه می کند، مانند ابزارهایی که از چشمک زدن طبیعی پشتیبانی می کنند.

بیشتر بخوانید🚀🚀🚀🚀🚀🚀: هک گوشی

نحوه دفاع در برابر دیپ فیک

شرکتها، سازمانها و سازمانهای دولتی، مانند آژانس پروژههای تحقیقاتی پیشرفته دفاعی وزارت دفاع ایالات متحده، در حال توسعه فناوری برای شناسایی و مسدود کردن دیپفیک هستند. برخی از شرکتهای رسانههای اجتماعی از فناوری بلاک چین برای تأیید منبع ویدیوها و تصاویر قبل از ورود آنها به پلتفرمهایشان استفاده میکنند. به این ترتیب، منابع قابل اعتماد ایجاد می شود و از جعلی ها جلوگیری می شود. در همین راستا، فیس بوک و توییتر هر دو دیپ فیک های مخرب را ممنوع کرده اند.

نرم افزار حفاظت Deepfake از شرکت های زیر موجود است:

Adobe سیستمی دارد که به سازندگان اجازه میدهد امضایی را به ویدیوها و عکسها با جزئیات مربوط به ساخت آنها اضافه کنند.

مایکروسافت دارای نرمافزار تشخیص عمیق جعلی مبتنی بر هوش مصنوعی است که فیلمها و عکسها را تجزیه و تحلیل میکند تا یک امتیاز اطمینان ارائه کند که نشان میدهد آیا رسانه دستکاری شده است یا خیر.

عملیات Minerva از کاتالوگهای دیپفیکهایی که قبلاً کشف شدهاند استفاده میکند تا تشخیص دهد که آیا یک ویدیوی جدید صرفاً اصلاح یک جعلی موجود است که کشف شده و اثر انگشت دیجیتالی به آن داده شده است.

Sensity یک پلت فرم تشخیص ارائه می دهد که از یادگیری عمیق برای شناسایی نشانه های رسانه های دیپ فیک استفاده می کند، به همان روشی که ابزارهای ضد بدافزار به دنبال امضاهای ویروس و بدافزار هستند. هنگامی که کاربران یک دیپ فیک را مشاهده می کنند، از طریق ایمیل هشدار داده می شود.

نمونه های قابل توجه Deep fake

چندین نمونه قابل توجه از دیپ فیک وجود دارد، از جمله موارد زیر:

مارک زاکربرگ، بنیانگذار فیس بوک، قربانی یک دیپ فیک شد که نشان می داد فیس بوک چگونه کاربران خود را “مالک” می کند. این ویدئو برای نشان دادن اینکه چگونه مردم می توانند از پلتفرم های رسانه های اجتماعی مانند فیس بوک برای فریب مردم استفاده کنند طراحی شده است.

جو بایدن، رئیسجمهور ایالات متحده در سال ۲۰۲۰ قربانی دیپفیکهای متعددی شد که او را در حالات اغراقآمیز زوال شناختی نشان میداد تا بر انتخابات ریاستجمهوری تأثیر بگذارد. رؤسای جمهور باراک اوباما و دونالد ترامپ نیز قربانی ویدیوهای دیپ فیک شده اند که برخی برای انتشار اطلاعات نادرست و برخی به عنوان طنز و سرگرمی هستند.

در طول تهاجم روسیه به اوکراین در سال 2022، رئیس جمهور اوکراین ولودومیر زلنسکی به تصویر کشیده شد که به سربازانش می گوید تسلیم روس ها شوند.

تاریخچه فناوری هوش مصنوعی عمیق

هوش مصنوعی Deepfake یک فناوری نسبتا جدید است که منشاء آن دستکاری عکس ها از طریق برنامه هایی مانند Adobe Photoshop است. در اواسط دهه 2010، قدرت محاسباتی ارزان، مجموعه دادههای بزرگ، هوش مصنوعی و فناوری یادگیری ماشین، همگی برای بهبود پیچیدگی الگوریتمهای یادگیری عمیق ترکیب شدند.

سال 2014، GAN، فناوری در قلب دیپ فیک ها، توسط محقق دانشگاه مونترال، یان گودفلو، توسعه یافت. در سال 2017، یک کاربر ناشناس Reddit به نام “deepfakes” شروع به انتشار ویدیوهای دیپ فیک از افراد مشهور و همچنین یک ابزار GAN کرد که به کاربران اجازه می داد چهره ها را در ویدیوها عوض کنند. این موارد در اینترنت و شبکه های اجتماعی منتشر شد.

محبوبیت ناگهانی محتوای دیپفیک، شرکتهای فناوری مانند فیسبوک، گوگل و مایکروسافت را بر آن داشت تا روی توسعه ابزارهایی برای شناسایی دیپفیک سرمایهگذاری کنند. علیرغم تلاشهای شرکتهای فناوری و دولتها برای مبارزه با دیپفیک و مقابله با چالش تشخیص دیپفیک، این فناوری همچنان به پیشرفت خود ادامه میدهد و تصاویر و ویدیوهای دیپفیک متقاعدکنندهای را تولید میکند.

دیپ فیک در حالت عادی برای شما غیر قابل تشخیص است

چرا این نوع از هوش مصنوعی مهم است؟

چرا مهم است: ویدیوهای Deepfake یک تهدید رو به رشد هستند. به گفته گارتنر، شرکت ها تا 188 میلیارد دلار در راه حل های امنیت سایبری هزینه خواهند کرد. همچنین تشخیص این ویدیوهای جعلی عمیق در زمان واقعی دشوار است – برنامه های تشخیص برای تجزیه و تحلیل نیاز به آپلود ویدیوها دارند و سپس ساعت ها منتظر نتایج هستند.

فریب ناشی از دیپفیکها میتواند باعث آسیب و پیامدهای منفی مانند کاهش اعتماد به رسانهها شود. FakeCatcher به بازگرداندن اعتماد به کاربران کمک می کند تا بین محتوای واقعی و جعلی تمایز قائل شوند.

چندین مورد استفاده بالقوه برای FakeCatcher وجود دارد. پلتفرمهای رسانههای اجتماعی میتوانند از این فناوری برای جلوگیری از آپلود ویدیوهای مضر دیپفیک توسط کاربران استفاده کنند. سازمان های خبری جهانی می توانند از این آشکارساز برای جلوگیری از تقویت ناخواسته ویدیوهای دستکاری شده استفاده کنند. و سازمانهای غیرانتفاعی میتوانند از این پلتفرم برای دموکراتیک کردن تشخیص دیپفیک برای همه استفاده کنند.

چگونه یک دیپ فیک درست کنیم و این کار چقدر سخت است؟

دیپفیکها میتوانند مضر باشند، اما ایجاد یک دیپفیک که تشخیص آن سخت باشد، آسان نیست. ایجاد دیپ فیک امروزه نیاز به استفاده از واحد پردازش گرافیکی (GPU) دارد. برای ایجاد یک دیپ فیک متقاعد کننده، یک GPU از نوع بازی که چند هزار دلار هزینه دارد، می تواند کافی باشد. نرم افزار ایجاد دیپ فیک رایگان، متن باز و به راحتی دانلود می شود. با این حال، مهارت های قابل توجه ویرایش گرافیکی و دوبله صوتی مورد نیاز برای ایجاد یک دیپ فیک قابل باور رایج نیستند. علاوه بر این، کار مورد نیاز برای ایجاد چنین دیپ فیک نیازمند سرمایه گذاری زمانی چند هفته تا ماه برای آموزش مدل و رفع نواقص است.

1-Gathering of source and destination video (CPU)

جمعآوری ویدیوی مبدأ و مقصد (CPU) – حداقل چندین دقیقه فیلم منبع و مقصد 4K مورد نیاز است. ویدئوها باید محدوده مشابهی از حالات صورت، حرکات چشم و چرخش سر را نشان دهند. آخرین نکته مهم این است که هویت مبدا و مقصد باید از قبل شبیه به هم باشند. آنها باید شکل و اندازه سر و صورت مشابه، موهای سر و صورت مشابه، رنگ پوست و جنسیت یکسان داشته باشند. در غیر این صورت، فرآیند مبادله این تفاوتها را بهعنوان مصنوعات بصری نشان میدهد و حتی ممکن است پس پردازش قابل توجهی نتواند این مصنوعات را حذف کند.

2-استخراج (CPU/GPU)

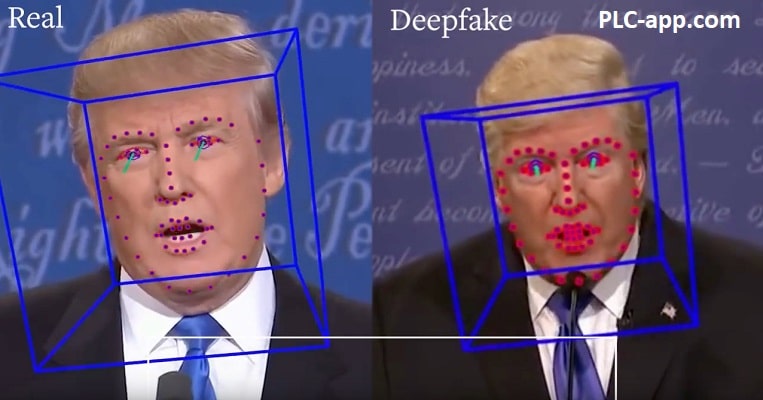

در این مرحله، هر ویدیو به فریم تقسیم میشود. در هر فریم، چهره مشخص میشود (معمولاً با استفاده از مدل DNN)، و تقریباً 30 نقطه عطف چهره شناسایی میشوند تا به عنوان نقاط لنگر برای مدل برای یادگیری مکان ویژگیهای صورت عمل کنند. یک تصویر نمونه از چارچوب FaceSwap در شکل 2 در زیر نشان داده شده است.

3. آموزش (GPU)

سپس هر مجموعه از چهره های تراز شده به شبکه آموزشی وارد می شود. یک شماتیک کلی از یک شبکه رمزگذار-رمزگشا برای آموزش و تبدیل در شکل 1 در بالا نشان داده شده است. توجه داشته باشید که دسته هایی از وجه های ورودی A و B هم تراز و ماسک شده (پس از مرحله استخراج) هر دو به یک شبکه رمزگذار تغذیه می شوند. خروجی شبکه رمزگذار نمایشی از تمام چهره های ورودی در یک فضای برداری با ابعاد پایین تر است که فضای پنهان نامیده می شود. سپس این اشیاء فضای پنهان هر کدام به طور جداگانه از طریق شبکههای رمزگشا برای چهرههای A و B که تلاش میکنند هر مجموعه از چهرهها را به طور جداگانه تولید یا بازسازی کنند، منتقل میشوند.

چهرههای تولید شده با چهرههای اصلی مقایسه میشوند، تابع تلفات محاسبه میشود، پس انتشار رخ میدهد، و وزنهای شبکههای رمزگشا و رمزگذار بهروز میشوند. این اتفاق برای دسته دیگری از چهره ها تا زمانی که تعداد دوره های مورد نظر به دست آید، رخ می دهد. کاربر تصمیم می گیرد که چه زمانی آموزش را با بازرسی بصری چهره ها از نظر کیفیت خاتمه دهد یا زمانی که ارزش از دست دادن بیشتر از این کاهش پیدا نکند. مواقعی وجود دارد که وضوح یا کیفیت ورودی به دلایل مختلف مانع از رسیدن مقدار تلفات به مقدار دلخواه می شود. به احتمال زیاد در این مورد، هیچ مقدار آموزش یا پس پردازش منجر به یک دیپ فیک متقاعد کننده نخواهد شد.

4. تبدیل (CPU/GPU)

دیپ فیک در مرحله تبدیل ایجاد می شود. اگر کسی بخواهد یک فیسواپ ایجاد کند، جایی که وجه A باید با B جایگزین شود، جریان در قسمت پایین شکل 1 بالا استفاده میشود. در اینجا، وجه های ورودی A که تراز شده و پوشانده شده اند به رمزگذار وارد می شوند. به یاد بیاورید که این رمزگذار نمایشی برای هر دو صورت A و B یاد گرفته است. هنگامی که خروجی رمزگذار به رمزگشای B ارسال می شود، سعی می کند چهره B را با هویت A جایگزین کند. در اینجا، هیچ یادگیری یا یادگیری وجود ندارد. آموزشی که انجام می شود مرحله تبدیل یک عبور یک طرفه از مجموعه ای از چهره های ورودی از طریق شبکه رمزگذار-رمزگشا است. خروجی فرآیند تبدیل مجموعهای از فریمها است که باید توسط نرمافزارهای دیگر کنار هم قرار گیرند تا تبدیل به ویدیو شوند.