کلاهبرداری ارز دیجیتال + مهمترین نکات امنیتی برای حفظ دارایی شما 🟢

ژانویه 30, 2024

بدافزار زئوس (Zeus) چیست؟ + هدف آن + انواع آن + روش های پیشگیری از حمله🟢

ژانویه 31, 2024در سال 2010، یک مفهوم متحول کننده در حوزه ذخیره سازی داده ها و تجزیه و تحلیل ریشه گرفت به اسم دریاچه داده. این اصطلاح توسط جیمز دیکسون، مهندس Back-End Java، Data و Business Intelligence ابداع شد و دوران جدیدی را در نحوه ذخیره، مدیریت و تجزیه و تحلیل دادههای سازمانها آغاز کرد. دریاچههای داده بهعنوان مخازن وسیعی پدیدار شدند که در آن دادههای خام در طبیعیترین حالت خود میتوانستند آزادانه با هم ترکیب شوند و انعطافپذیری و مقیاسپذیری بیسابقهای را ارائه دهند. در این مقاله می خواهیم با شما در مورد دریاچه داده صحبت کنیم.

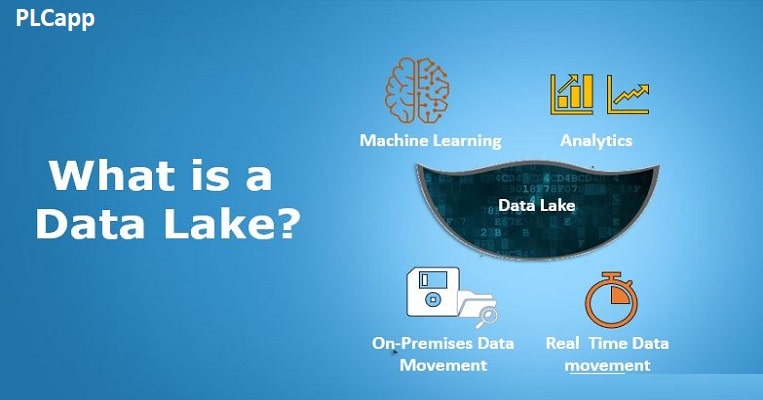

دریاچه داده (Data Lake) چیست؟

دریاچه داده یک مخزن متمرکز است که برای نگهداری حجم وسیعی از داده ها در قالب اصلی و خام خود طراحی شده است . خواه ساختار یافته، نیمه ساختاریافته یا بدون ساختار. در واقع دریاچه داده قبل از شناسایی مورد استفاده خاص، داده ها را ذخیره می کند. این انعطاف پذیری تطبیق انواع داده ها و نیازهای تجزیه و تحلیلی را آسان تر می کند زیرا آنها در طول زمان تکامل می یابند. اصطلاح دریاچه داده به خودی خود استعاری است و تصویری از حجم بزرگی از آب را تداعی می کند که توسط جریان های متعدد تغذیه می شود و هر کدام داده های جدیدی را برای ذخیره و تجزیه و تحلیل به ارمغان می آورد.

دریاچه داده به جای تکیه بر ساختارهای سلسله مراتبی سنتی و طرحواره های از پیش تعریف شده، مانند مورد انبارهای داده، از معماری مسطح استفاده می کند. این ساختار با روشهای مهندسی دادهها که شامل ذخیرهسازی اشیا است، کارآمد میشود. چنین مدل ذخیرهسازی شی، برچسبگذاری ابرداده، ترکیب شناسههای منحصربهفرد، سادهسازی بازیابی دادهها و بهبود عملکرد را امکانپذیر میسازد.

با بازگشت به موضوع، نکته کلیدی برای درک یک دریاچه داده، ساخت و ساز آن نیست، بلکه قابلیت های آن است. این یک پلت فرم همه کاره برای کاوش، پالایش و تجزیه و تحلیل پتابایت اطلاعات است که به طور مداوم از منابع داده های مختلف وارد می شود.

چه کسی به دریاچه داده نیاز دارد؟

اگر پیچیدگیهای کلان دادهها برای سیستمهای موجود شما بسیار زیاد است، ممکن است یک دریاچه داده راهحلی باشد که به دنبال آن هستید.

سازمان هایی که معمولاً از دریاچه های داده سود می برند عبارتند از:

آنهایی که قصد دارند یک فرهنگ تحلیلی قوی ایجاد کنند، جایی که داده ها ابتدا ذخیره می شوند و سپس در دسترس تیم های مختلف قرار می گیرند تا بینش خود را استخراج کنند.

کسب و کارهایی که به دنبال بینش های پیشرفته از طریق آزمایش های تحلیلی یا مدل های یادگیری ماشین هستند. و

سازمان هایی که تحقیقات گسترده ای را با نیاز به ادغام داده ها از حوزه های مختلف برای تجزیه و تحلیل پیچیده انجام می دهند.

اگر سازمان شما در یکی از این دسته بندی ها قرار می گیرد و به دنبال پیاده سازی راه حل های پیشرفته مدیریت داده و تجزیه و تحلیل هستید، به خواندن ادامه دهید تا دریاچه های داده چگونه کار می کنند و چگونه می توانند برای کسب و کار شما مفید باشند.

مقایسه دریاچه داده و انبار داده

انبارهای داده سنتی چندین دهه است که وجود دارند. این سیستمها که در ابتدا برای پشتیبانی از تجزیه و تحلیل طراحی شده بودند، به سازمانها اجازه میدهند تا دادههای خود را برای بینش، روندها و تصمیمگیری جستجو کنند.

انبار داده نیاز به یک طرحواره – یک ساختار رسمی برای نحوه سازماندهی داده ها – برای تحمیل از قبل دارند. به دلیل طرحواره روی نوشتن، انبارهای داده انعطاف کمتری دارند. با این حال، آنها می توانند هزاران پرسش روزانه را برای کارهایی مانند گزارش و پیش بینی شرایط کسب و کار انجام دهند.

تمایز دیگر انتخاب ETL در مقابل ELT است: در انبارهای داده، فرآیندهای Extract و Transform معمولاً قبل از بارگیری داده ها در انبار اتفاق می افتد. بسیاری از سازمانها همچنین دادهها را که مخازن ذخیرهسازی اختصاصی برای خطوط تجاری یا گروههای کاری خاص هستند، مستقر میکنند. برخلاف DW های سنتی، انبارهای داده ابری مانند Snowflake، BigQuery و Redshift مجهز به ویژگی های پیشرفته هستند. در مقاله اختصاصی ما درباره تفاوت ها بیشتر بدانید.

از سوی دیگر، دریاچههای داده نوآوری جدیدتری هستند که برای مدیریت انواع دادههای مدرن مانند وبلاگها، جریانهای کلیک و فعالیت رسانههای اجتماعی، اغلب در قالبهای نیمه ساختاریافته یا بدون ساختار طراحی شدهاند.

نکته

بر خلاف انبارهای داده، دریاچههای داده یک رویکرد طرحواره در خواندن را امکانپذیر میکنند و انعطافپذیری بیشتری را در ذخیرهسازی دادهها ممکن میسازند. این آنها را برای فعالیت های تحلیلی پیشرفته تر، از جمله تجزیه و تحلیل بلادرنگ و یادگیری ماشینی ایده آل می کند. در حالی که انعطاف پذیر هستند، ممکن است برای اطمینان از کیفیت و امنیت داده ها به مدیریت گسترده تری نیاز داشته باشند. همچنین، دریاچه های داده از فرآیندهای ELT (Extract, Load, Transform) پشتیبانی می کنند که در آن تبدیل می تواند پس از بارگیری داده ها در یک فروشگاه متمرکز اتفاق بیفتد.

دریاچه داده می تواند به عنوان مهمترین منبع برای ذخیره اطلاعات استفاده شود

بلع داده ها (Data Ingestion)

هضم داده فرآیند وارد کردن داده ها به دریاچه داده از منابع مختلف است. این به عنوان دروازه ای عمل می کند که داده ها از طریق آن وارد دریاچه می شوند، چه در حالت دسته ای یا در زمان واقعی، قبل از پردازش بیشتر.

مصرف دسته ای یک روش برنامه ریزی شده و مبتنی بر فاصله زمانی برای وارد کردن داده است. برای مثال، ممکن است تنظیم شود که به صورت شبانه یا هفتگی اجرا شود و تکه های بزرگی از داده را در یک زمان منتقل کند. ابزارهایی که اغلب برای مصرف دسته ای استفاده می شوند عبارتند از Apache NiFi، Flume و ابزارهای سنتی ETL مانند Talend و Microsoft SSIS. هضم بلادرنگ بلافاصله دادهها را در دریاچه داده به هنگام تولید میآورد. این برای برنامه های حساس به زمان مانند تشخیص تقلب یا تجزیه و تحلیل بلادرنگ بسیار مهم است. آپاچی کافکا و AWS Kinesis ابزارهای محبوبی برای مدیریت زمان واقعی داده ها هستند.

با یکسان کردن قابلیتهای پردازش دادههای دستهای و جریانی، لایه جذب اغلب از چندین پروتکل، API یا روشهای اتصال برای پیوند با منابع داده داخلی و خارجی مختلف که قبلاً در مورد آن صحبت کردیم استفاده میکند. تنوع پروتکل ها جریان داده های روان را تضمین می کند و طبیعت ناهمگون منابع داده را تامین می کند.

ذخیره سازی و پردازش داده ها

لایه ذخیرهسازی و پردازش دادهها جایی است که دادههای جذب شده در آن قرار میگیرند و دستخوش تغییراتی میشوند تا برای تجزیه و تحلیل در دسترستر و ارزشمندتر شوند. این لایه به طور کلی برای سهولت مدیریت و کارایی گردش کار به مناطق مختلف تقسیم می شود.

بخش ذخیره داده های خام در ابتدا، داده های دریافت شده در جایی قرار می گیرند که معمولاً به عنوان منطقه خام یا فرود نامیده می شود. در این مرحله، داده ها در قالب اصلی خود هستند – خواه ساختار یافته، نیمه ساختاریافته یا بدون ساختار باشد. ذخیرهسازی دادههای خام بهعنوان یک مخزن عمل میکند که در آن دادهها قبل از هر گونه پاکسازی یا تبدیل مرحلهبندی میشوند. این منطقه از راه حل های ذخیره سازی مانند Hadoop HDFS، Amazon S3 یا Azure Blob Storage استفاده می کند.

بخش تحول. پس از اقامت در منطقه خام، داده ها دستخوش تغییرات مختلفی می شوند. این بخش بسیار متنوع است و از پردازش دسته ای و جریانی پشتیبانی می کند.

بیشتر بخوانید📘📘📘📘📘👈👈👈👈» نشت اطلاعات

در اینجا چند فرآیند تبدیلی وجود دارد که در این لایه اتفاق می افتد:

فرآیند پاکسازی داده ها شامل حذف یا تصحیح سوابق نادرست، مغایرت ها یا ناهماهنگی ها در داده ها است.

غنی سازی داده ها با ترکیب اطلاعات یا زمینه اضافی به مجموعه داده های اصلی ارزش می افزاید.

عادی سازی داده ها را به یک قالب مشترک تغییر می دهد و از ثبات اطمینان حاصل می کند.

ساختاردهی اغلب شامل شکستن داده های بدون ساختار یا نیمه ساختار یافته به شکل ساختاریافته مناسب برای تجزیه و تحلیل است.

پس از این تبدیل ها، داده ها به چیزی تبدیل می شوند که اغلب به آن داده های قابل اعتماد می گویند. قابل اعتمادتر، تمیزتر، و برای مدل های مختلف تحلیلی و یادگیری ماشینی مناسب است.

داده ها را می توان به منطقه دیگری به نام منطقه داده تصفیه شده یا مطابقت یافته منتقل کرد. تغییر و ساختار اضافی ممکن است برای آماده سازی داده ها برای موارد استفاده خاص تجاری رخ دهد. داده های پالایش شده همان چیزی است که تحلیلگران و دانشمندان داده معمولاً با آن تعامل خواهند داشت. در دسترستر و کار کردن با آن آسانتر است و برای کارهای تجزیه و تحلیل، هوش تجاری و یادگیری ماشین ایدهآل است. ابزارهایی مانند Dremio یا Presto ممکن است برای جستجو در این داده های تصفیه شده استفاده شوند.

مصرف داده

در نهایت به لایه مصرف داده می رسیم. اینجاست که ثمره تمام تلاش های قبلی محقق می شود. داده های صیقلی و قابل اعتماد اکنون برای کاربران نهایی آماده است و از طریق ابزارهای هوش تجاری مانند Tableau یا Power BI در معرض دید قرار می گیرد. همچنین اینجاست که نقشهای تخصصی مانند تحلیلگران داده، تحلیلگران کسبوکار و تصمیمگیرندگان بازی میکنند و از دادههای پردازش شده برای هدایت تصمیمهای تجاری استفاده میکنند.

لایه حاکمیت، امنیت و نظارت مقطعی

یک لایه فراگیر از حاکمیت، امنیت، نظارت و سرپرستی برای کل جریان داده در یک دریاچه داده جدایی ناپذیر است. این یک لایه خارج از جعبه نیست، معمولاً از طریق ترکیبی از پیکربندیها، ابزارهای شخص ثالث و تیمهای تخصصی پیادهسازی میشود.

حاکمیت قوانین، خط مشی ها و رویه هایی را برای دسترسی، کیفیت و قابلیت استفاده به داده ها ایجاد و اجرا می کند. این امر ثبات اطلاعات و استفاده مسئولانه را تضمین می کند. ابزارهایی مانند Apache Atlas یا Collibra میتوانند این لایه حاکمیتی را اضافه کنند و مدیریت خطمشی قوی و برچسبگذاری ابرداده (اطلاعات متنی در مورد دادههای ذخیرهشده) را ممکن میسازد.

پروتکل های امنیتی از دسترسی غیرمجاز به داده ها محافظت می کنند و از رعایت مقررات حفاظت از داده ها اطمینان می دهند. راه حل هایی مانند Varonis یا McAfee Total Protection برای پیشگیری از از دست دادن داده ها می توانند برای تقویت این جنبه از دریاچه داده شما یکپارچه شوند. مانیتورینگ و فرآیندهای ELT (Extract, Load, Transform) نظارت و جریان دادهها را از شکل خام آن به قالبهای قابل استفادهتر مدیریت میکنند. ابزارهایی مانند Talend یا Apache NiFi در ساده سازی این فرآیندها و در عین حال حفظ استانداردهای عملکرد تخصص دارند.

دریاچه داده ها مانند هر انبار ذخیره دیگری عمل می کند اما پویا تر است

Azure Data Lake Storage

Azure Data Lake Storage (ADLS) یک راه حل غنی از ویژگی های دریاچه داده توسط Microsoft Azure است که به طور خاص برای شرکت هایی طراحی شده است که در خدمات Azure سرمایه گذاری می کنند یا علاقه مند به آن هستند. برخلاف یک سرویس جداگانه، Data Lake Storage Gen2 که به تازگی راه اندازی شده است، بهبود یافته ای از Azure Blob Storage است که مجموعه ای از قابلیت ها را برای مدیریت داده ها ارائه می دهد.

امنیت در سطح سازمانی این پلتفرم رمزگذاری داده های داخلی را فراهم می کند و سازمان ها را قادر می سازد تا داده های خود را در حالت استراحت ایمن کنند. علاوه بر این، سیاستهای کنترل دسترسی دقیق و قابلیتهای حسابرسی جامع را ارائه میدهد که برای رعایت استانداردهای امنیتی و انطباق دقیق ضروری هستند.

پشتیبانی از لینک خصوصی Azure. ADLS از Azure Private Link پشتیبانی می کند، قابلیتی که امکان دسترسی ایمن و خصوصی به دریاچه های داده از طریق اتصال شبکه خصوصی را فراهم می کند. یکپارچگی و تطبیق پذیری. Azure Data Lake Storage به طور یکپارچه با فروشگاههای عملیاتی و انبارهای داده ادغام میشود و امکان یک استراتژی مدیریت داده منسجم را فراهم میکند. قابلیت حجم کاری بالا این پلتفرم میتواند بارهای کاری بالایی را تحمل کند و به کاربران امکان میدهد تحلیلهای پیشرفته را اجرا کنند و حجم زیادی از دادهها را ذخیره کنند.

Snowflake

Snowflake چشم انداز دریاچه داده را با پلتفرم ابری خود بازتعریف کرده است و به عنوان فروشنده برتر در این زمینه ظاهر شده است. بر خلاف دریاچههای داده سنتی، Snowflake خود را به عنوان یک ابر داده معرفی میکند که سیلوهای داده را تجزیه میکند و امکان یکپارچهسازی یکپارچه دادههای ساختاریافته، نیمهساختار یافته و بدون ساختار را فراهم میکند. این پلتفرم به دلیل سرعت و قابلیت اطمینان خود شناخته شده است که توسط یک موتور پردازش الاستیک طراحی شده است که مشکلات همزمانی و اختلاف منابع را حذف می کند.

کلید موفقیت Snowflake تمرکز آن بر انعطاف پذیری و سادگی است که اغلب توسط متخصصان داده به عنوان پلتفرمی که “فقط کار می کند” توصیف می کنند. ویژگی های پیشرفته ای مانند Snowpark و Snowpipe را ارائه می دهد که برنامه نویسی چند زبانه و جریان داده را تسهیل می کند. قابلیتهای ذخیرهسازی کارآمد آن شامل ریز پارتیشنبندی خودکار، رمزگذاری استراحت و انتقال، و سازگاری با ذخیرهسازی اشیاء ابری موجود، حذف حرکت دادهها است.

دریاچههای داده راهحلهای همهکارهای هستند که نیازهای مختلف ذخیرهسازی داده و نیازهای تحلیلی را برآورده میکنند. در زیر چند مورد استفاده کلیدی و نمونههای واقعی وجود دارد که بر اهمیت روزافزون دریاچههای داده و کاربرد گسترده آن تأکید میکند.

بیشتر بخوانید📘📘📘📘📘👈👈👈👈» تفاوت ویروس و بدافزار

تجزیه و تحلیل

تجزیه و تحلیل بلادرنگ شامل تجزیه و تحلیل داده ها به محض در دسترس شدن است. این در امور مالی، جایی که قیمت سهام در چند ثانیه در نوسان است، و در تجارت الکترونیک، که در آن سیستمهای توصیهکننده بلادرنگ میتوانند فروش را افزایش دهند، بسیار مهم است. دریاچههای داده در تجزیه و تحلیل بلادرنگ برتری دارند زیرا میتوانند حجم بالایی از دادههای ورودی را در خود جای دهند، از تنوع دادهها پشتیبانی کنند، بازیابی با تأخیر کم را ارائه دهند، به خوبی با چارچوبهای پردازش جریانی مانند آپاچی کافکا ادغام شوند، و انعطافپذیری با قابلیتهای طرحواره در خواندن ارائه کنند. .

چهار جزء مختلف می تواند دریاچه داده را تشکیل دهد

تجزیه و تحلیل اینترنت اشیا

اینترنت اشیا (IoT) حجم وسیعی از داده ها را از دستگاه هایی مانند حسگرها، دوربین ها و ماشین آلات تولید می کند. دریاچه های داده می توانند این حجم و تنوع را مدیریت کنند و به صنایع اجازه می دهند تصمیمات آگاهانه تری بگیرند.

جنرال الکتریک از دریاچه دادههای صنعتی خود برای رسیدگی به دادههای دستگاه اینترنت اشیا در زمان واقعی استفاده میکند و فرآیندهای تولید بهینه و تعمیر و نگهداری پیشبینیکننده را در بخشهای حمل و نقل هوایی و بهداشتی ممکن میسازد. همچنین، زیرمجموعه جنرال الکتریک – GE Healthcare (GEHC) – یک معماری خانه داده جدید را با استفاده از خدمات AWS با دریاچه داده آمازون S3 برای ذخیره داده های سازمانی و رویدادهای خام اتخاذ کرد.

جستجوی پیشرفته و شخصی سازی

قابلیتهای جستجوی پیشرفته و توصیههای شخصیشده نیاز به تجزیه و تحلیل رفتار و ترجیحات کاربر دارد که میتواند پیچیده و متنوع باشد. دریاچه های داده با اجازه دادن به شرکت ها برای ذخیره مجموعه داده های متنوعی که می توانند برای این عملکردهای خاص تجزیه و تحلیل شوند، از این امر پشتیبانی می کنند. به عنوان مثال، نتفلیکس از یک دریاچه داده برای ذخیره داده های بیننده استفاده می کند و از تجزیه و تحلیل پیشرفته برای ارائه توصیه های مشاهده شخصی تر استفاده می کند.

به حداکثر رساندن پتانسیل Data Lake

برای اطمینان از اینکه دریاچه داده شما به جای یک بدهی دارایی است، بهترین شیوه های زیر را رعایت کنید.

برنامه ریزی استراتژیک

اهداف تجاری خود را تعیین کنید و انواع داده هایی را که ذخیره می کنید مشخص کنید. این راه را برای یک دریاچه داده به خوبی سازماندهی شده هموار می کند.

تضمین کیفیت

بررسیهای اعتبارسنجی و روشهای پاکسازی دادهها را برای حفظ قابلیت اطمینان و ارزش دادههای ذخیرهشده خود یکپارچه کنید.

افزایش عملکرد

از استراتژی هایی مانند نمایه سازی، پارتیشن بندی و ذخیره سازی برای افزایش عملکرد پرس و جو و پاسخگویی کلی داده ها استفاده کنید.

امنیت قوی به طور منظم ممیزی انجام دهید و کنترل های دسترسی مبتنی بر نقش را اعمال کنید. همچنین، از رمزگذاری در حالت استراحت برای محافظت از داده های حساس استفاده کنید. با ادغام دقیق این شیوههای کلیدی، دریاچه دادههای شما در موقعیت بهینه قرار میگیرد تا بینشهای معنیداری ارائه دهد، در نتیجه تصمیمگیری آگاهانه در سراسر سازمان شما تسهیل میشود.